Most segíthet eldönteni, hogy kit öljenek meg az első gépek!

Tavaly év végén írtunk róla részletesen, hogy az önmagukat vezető autóknak, illetve az autót irányító számítógépes programnak extrém helyzetekben nehéz morális döntéseket kell majd hoznia.

Ha kiszalad egy gyerek az autó elé, és nem kerülhető el az ütközés, akkor az automata inkább rántsa félre a kormányt, és sodorja veszélybe az utasokat, vagy inkább gázolja el az úttestre tévedt gyereket?

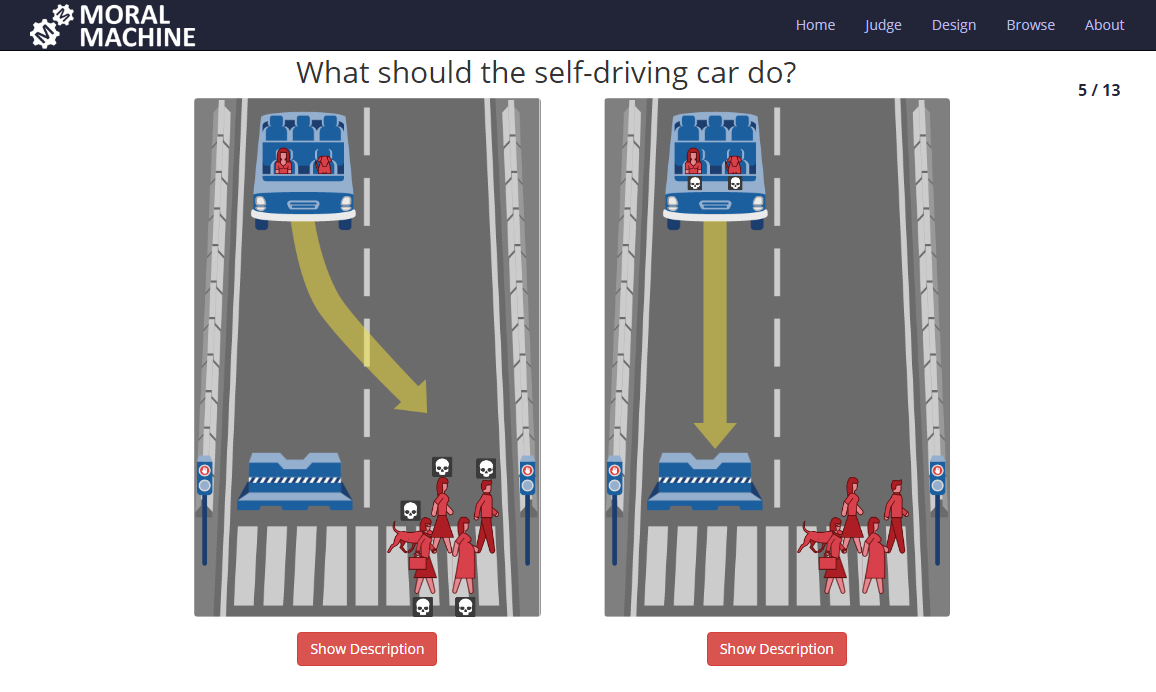

Az amerikai MIT kutatói Moral Machine nevű oldalukon azt próbálják felmérni, hogy az emberek hogyan döntenének ilyen lehetetlen szituációkban.

Tizenhárom kérdésre kell válaszolni. Egyszerűekre, mint hogy inkább kutyákat vagy inkább embereket üssön el az autó, ha csak ezek a választások, és nehezebbeket, mint hogy az autóban ülő egy utast védje a szoftver, vagy az úttesten lévő több embert.

A válaszadás alapján azt próbálják megállapítani, hogy ilyen élet-halál morális kérdésekben milyen szempontok számítanak leginkább az embereknek.

- Hogy az áldozat férfi-e vagy nő?

- Hogy fiatal-e vagy öreg?

- Hogy a társadalom hasznos tagja-e vagy bűnöző?

- Hogy megszegte-e közlekedési szabályokat, vagy sem?

- Hogy a kocsi utasa vagy gyalogos?

Érdemes figyelmesen végigmenni a kérdéseken, a végén azt is meg lehet nézni, hogy a válaszadók többsége hogyan döntött egyes helyzetekben. Sőt van egy "Design" gomb is, amivel saját dilemmát lehet létrehozni.