A tudomány publikációs válsága (és egy lehetséges kiút)

Húsz-harminc évvel ezelőtt még viszonylag egyértelmű volt, miképpen történik a tudományos ismeretek terjesztése: a kutató, vagy kutatói pályára aspiráló fiatal egy érdekes megfigyelését röviden leírta, azt elküldte a megfelelő újságnak, ahol a szerkesztő saját hatáskörében döntött arról, hogy megjelenteti-e vagy sem (ha szükségesnek érezte, esetleg kikérte más, szakmabeli kutatók véleményét), majd - ha publikálásra méltónak találtatott - a szerkesztőség betördelte az irományt, a nyomda kinyomtatta, a posta kivitte az előfizetőkhöz, akik elolvasták azt. A folyamatban mindenkinek viszonylag jól meghatározott szerepe volt, a kutató kutatott, az újság pedig biztosította, hogy a szöveg eljusson minél több olvasóhoz. A műveletnek természetesen volt egy költsége, hiszen a szerkesztés, nyomtatás, postázás nem ingyenes, de ezt mindenki értette és elfogadta.

Az elmúlt évtizedekben azonban valami elromlott és ahogy napjaink egyik legendás genetikusa, Alfonso Martinez-Arias fogalmaz, a tudományos újságkiadás a kutatók publikálását elősegítő médiumból egy fogyasztói termékké változott, ami nem kiszolgálja a kutatókat, hanem ki- és felhasználja azokat az üzleti modelljéhez. Ráadásul paradox módon úgy történt mindez, hogy napjaink technológiájával szinte teljesen megkerülhetővé vált a kiadók szerepe.

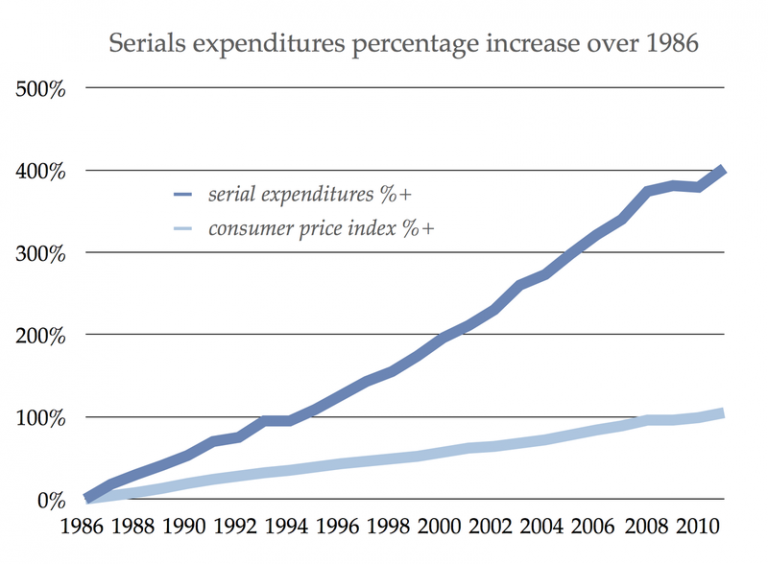

Ha valaki járatlan a tudományos publikálás idegörlő labirintusában, az nyilván táguló szemekkel olvassa, hogy ez talán az egyetlen olyan niche a lapkiadás világában, amely olyan üzleti modellel dolgozik, ahol kiadás jóformán nincs is, csak bevétel. Ez az a világ, ahol a legnívósabb munka publikációjáért sem az újság fizet, hanem az azt publikálni vágyó kutatók, a szerkesztőségi munka legidőigényesebb részét (a beküldött munka minőségének elbírálását) más kutatók végzik, ingyen, végül - általában - a kész termékért pedig megint csak fizetnek, további kutatók. S mivel az internet megjelenésével a publikálás platformja is egyre inkább a drága és lassú papírról áttevődött az olcsó elektronikus formátumra, még ezzel a költséggel sem kell a kiadóknak számolniuk. Nem csoda, hogy a publikációs világ egyik óriásának számító holland Elsevier kiadó közel 35%-os haszonkulccsal dolgozik (azaz profitábilisabb, mint mondjuk az Apple).

Ha pedig ezen a ponton legyintenél, kedves olvasó, hogy mindenki saját hülyeségének kovácsa és a kutatók megérdemlik, ha ennyire ostobák, akkor még álljon itt két fontos információ, ami hátha elgondolkoztat: a kutatókra részben a társadalmi elvárások kényszerítik rá, hogy ezt a publikálási utat válasszák, illetve az Elsevier (és más kiadók) obszcén profitja többnyire közpénzből származik.

Hogy is van ez?

A kutatói pálya az elmúlt húsz évben egy viszonylag alulfizetett, de cserében elmélyülést és szellemi szabadságot biztosító, kreatív értelmiségi elfoglaltságból az egyik legkompetitívebb, legidegőrlőbb, minimális szellemi szabadságot biztosító és továbbra is alulfizetett foglalkozássá vált. Történt mindez azért, mert ugyan a társadalom világszerte nagyon helyesen felismerte, hogy tudomány és az alapkutatás az egyik legfontosabb és nem mellesleg legkifizetődőbb befektetések egyike, és ezért igyekezett a fiatalokat ezekre a pályákra terelni, végső soron az (alap)kutatásra fordított anyagiak sehol nem követték a kutatást művelők számának ugrásszerű növekedését. Vagyis míg húsz, harminc évvel ezelőtt viszonylag jó eséllyel lehetett egy szellemes ötlettel pályázati pénzt kapni, ma már hiperkompetitív pályázatokon, végső soron a pályázók mindössze 5%-a nyer úgy, hogy ma már a bírálók sem biztosak abban, hogy pont ez az 5% a legjobb pályázat-e és nem mondjuk a következő 5-10%, mert igazából ez megmondhatatlan. A sikeres pályázáshoz bizonyítani kell, és a bizonyítás valamilyen "objektívnek" kikiáltott szempontrendszer szerint kell történjen, magyarán a pályáztatók azt is igyekeznek felmérni, hogy a pályázó korábbi munkája mennyire garantálja a sikeres tudományos program megvalósítását.

Ennek az objektivitásnak egy illuzórikus mérőszáma az úgynevezett "összesített impakt faktor", ami durva egyszerűsítésben azt kellene mutassa, hogy mennyire nívós helyeken publikált addig a pályázó. Az egyes újságoknak ugyanis minden évben újraszámolt impakt faktora (IF) van, ami kb. azt mutatja, hogy egy-egy cikkre hány hivatkozás született egy év alatt. A nagy IF-ú újságban publikálni így nem csak presztízs, hanem egyben a pályázati pénzek elnyerésének és a karrierépítésnek a fontos eszköze lett.

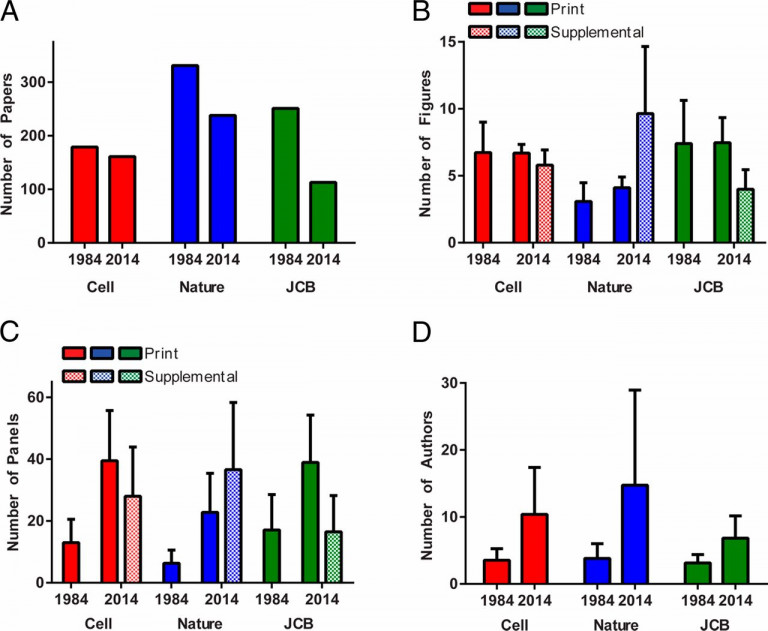

Mivel a legnagyobb presztizsű lapok megőrizték nyomtatott kiadásukat is, annak terjedelmi korlátaival, az évek során egyre szelektívebbek lehetnek, hiszen egyre több kutató szeretne publikálni náluk. A szelektivitás - elvileg - biztosíthatja, hogy tényleg a legnívósabb cikkek jelenjenek itt meg, ami tovább emeli az újság presztízsét és bebetonozza a brandjének fontosságát is. Épp ezért sokan, sok éven át, rengeteg pénzt és energiát beleölve hajlandók mindent megtenni egy ilyen cikkért - amit jól mutat, hogy a nagy újságokban egyre több szerző, egyre több időt áldoz arra, hogy egyre több információt zsúfoljon bele az egyes publikációkba.

Nem véletlen, hogy a brand-építésnek kiemelt szerepe van a tudományos lapoknál és az ismert, jól bejáratott címek (pl. Nature, Science, Cell, stb.) hihetetlenül nagy befolyással is rendelkeznek. Mivel mindenki szeretne itt publikálni, illetve mindenki igyekszik az itt megjelenő, igazán fontos cikkeket elolvasni, a kiadók kényelmes helyzetben vannak, mert mind a két oldaltól megkérhetik az árát annak, hogy ők ellássák a közvetítő szerepét. Ahogy említettem, borsos árat kérnek a cikk szerzőitől - akik többnyire költségvetési eredetű pályázati pénzeiket használják el erre -, és borsos árat kérnek az egyetemek, kutatóintézetek könyvtáraitól a hozzáférésért - amire azok szintén költségvetésből származó támogatási forrásokat használnak. (Még egyszer, mert ennek az abszurditását nem lehet elégszer kiemelni: a közpénzből végzett kutatás eredményét a társadalom nem ismerheti meg, csak ha hajlandó fizetni egy cégnek, aki már egy adag közpénzt elszedett a "szerkesztésért".)

Egyébként pont a brandépítés lassúsága, illetve az az apró, de nem elhanyagolható tény, hogy a sokat kritizált IF csak több év után jár egy lapnak (addig pedig kevesen válalják a kockázatot, hogy odaküldik a kéziratukat, ergo a kezdeti IF biztos alacsony lesz), azt is jelentik, hogy ez nem az a műfaj, ahol Adam Smith "láthatatlan keze" jól működne.

És az, hogy a tudományos lapkiadás egyértelműen egy olyan szeglete a gazdaságnak, amit csak „market failure”-ként lehet aposztrofálni, azt is jelenti, hogy a már befutott piaci szereplők kvázi monopolhelyzetben vannak, amit – mint az Elsevier haszonkulcsa is mutatja – egyáltalán nem szégyellnek kihasználni. Nagyon gyakran, a könyvtáraknak a lapok eléréseit csak csomagokban adják - vagyis azon lapok mellett, amire az adott intézetnek valóban szüksége van, muszáj előfizetnie olyanokra is, amit soha senki nem fog elolvasni. Ez pedig már olyan perverzió, ami ellen olyan egyetemek könyvtárai is lázadnak, mint a Harvard, vagy a Cornell. Ahogy azt pár éve a világhírű matematikus, Timothy Gowers jól körülírta, az Elsevier viselkedése egy agresszív kistérségi uzsoráséhoz hasonlítható, akit az indokolatlan profitján kívül senki és semmi nem érdekel, és nem válogat az eszközökben, ha valaki a profitját veszélyezteti.

Gowers egyébként maga is zászlóvivője volt négy éve annak a mozgalomnak, ami az Elsevier bojkottját tűzte ki célul, és nem kevesebb mint 15 000 aláírást össze is gyűjtött, de akkor (még ?) nem sikerült komolyabban megszorongatniuk a holland kiadóóriást. De lassú víz partot mos és a tudományos társadalom fokozódó elégedetlensége, illetve pár technikai újítás következtében talán mostanra összeállt a hagyományos publikálást alapjaiban megrengető "tökéletes vihar" minden feltétele.

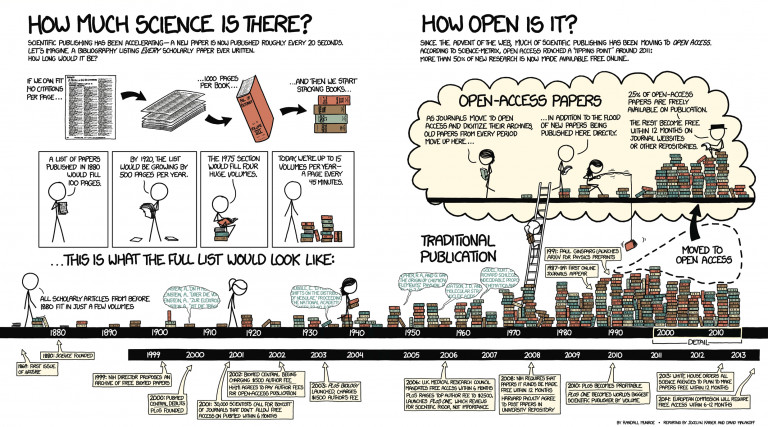

Az első fontos változás az elérési oldalról érkezett: az évek során egyre inkább egyértelművé vált, hogy közpénzből készült kutatási eredményeket pénzért továbbadni immorális, ráadásul egyben azt is jelenti, hogy sokkal kevesebben fogják elolvasni. Innen ered az Open Access (OA) mozgalom, amelynek célja, hogy a cikkek szabadon elérhetőek legyenek.

Mivel, nem túl meglepő módon, az OA feltünésekor a vezető kiadók nem mutattak túl nagy lelkesedést, hogy azt adoptálják, a célt igazán komolyan vevő kutatók új lapokat alapítottak. Így született először a Public Library of Science (PLOS) lapcsalád, majd később a PeerJ és eLife. Ez esetben a brand - és az első években az IF - hiányát a szakmai szerkesztőbizottságok húzónevei (számos Nobel-díjast találunk köztük), vagy a lapok mögé beálló alapítványok súlya pótolta részlegesen (az eLife-t a legfajsúlyosabb, orvosbiológiai kutatásokat (is) támogató alapítványok, brit Wellcome Trust, az amerikai Howard Hughes Medical Institute és a német Max-Planck-Gesellschaft támogatja). De így született bő egy hónappal ezelőtt Gowers bábáskodása mellett a Discrete Analysis is.

Mivel az utóbbi években az OA fokozatosan egyre erősebb politikai hátszelet is kapott (mostanra az EU és az amerikai NIH egyaránt megkövetelik, hogy az általuk folyósított pályázati pénzekből készülő kutatások, max. fél-egy évvel a megjelenésük után szabadon elérhetők legyenek), ma már egyre több "hagyományos" újság vagy teljesen átállt az OA formátumra, vagy egy hibrid formátumot adoptálva lehetővé teszi, hogy valaki megvegye a lehetőségét, hogy cikkét OA-ként közölje. Megvegye, ugyanis, az OA kiadói szempontból bevételkiesés az egyik oldalon, amit a másik oldalon kíméletlenül igyekszenek behajtani: azaz ha valaki OA cikket szeretne egy "hibrid" lapban, lényegesen többet kell fizetnie a kiadónak, mint egy hagyományos cikkért.

A legradikálisabb megoldás, ami egyben leginkább tükrözi a változó fogyasztói szokásokat, azonban Kazahsztánból érkezett. Itt hozta ugyanis létre Sci-Hub nevű oldalát egy Alexandra Elbakyan nevű egyetemista lány, amire a tudományos lapkiadás PirateBay-eként lehet tekinteni, bár még annál is vakmerőbb modellje van.

Amikor valaki, előfizetés nélkül próbál egy cikket letölteni, ha nem OA anyagról van szó, akkor az oldal felajánlja, hogy kb. 30 dollárért megveheti azt, esetleg az első oldalt teljesen ingyen el is olvashatja. Azonban a kiadó központi szervere IP címek alapján dönti el, hogy kit enged át ezen a tűzfalon és kit nem - az előfizető intézmények gépei számára épp ezért a cikk teljes verziója jelenik meg. Mivel azonban nem csak munkahelyi gépekről szeretnek a kutatók cikkeket olvasni, a legtöbb kutatóhely könyvtára proxy szervereket működtet, amiről otthonról is be lehet lépni, és amelyeken keresztül távolról is elérhetők a keresett publikációk.

A Sci-Hub működésének elve az, hogy összegyűjt számos ilyen proxy-belépő kódot (ezeket általában az oldal céljaival szimpatizáló, előfizetéssel rendelkező egyetemen alkalmazott kutatók adják meg), majd amikor a Sci-Hub rendszerébe valaki beüt egy linket, ami egy általa addig elérhetetlen cikkre mutat, a rendszer végigpörgeti a különböző proxy-kombinációkat egy olyant keresve, amivel az adott kiadó, adott lapja elérhetővé válik. De ezzel nincs vége a történetenek, mert a Sci-Hub egyben minden letöltött cikket elküld a LibGen nevű kalóz-adatbázisnak, és így egy egyre növekvő "szabadon hozzáférhető" könyvtár jön létre. Annak ellenére, hogy az egész dolog pár éve indult csak (és a Sci-Hub angol nyelven sokáig nem is volt elérhető), Elbakyan oldala napi százezres látogatottsággal bír, a 2012-ben létrejött LibGenben pedig már több mint 48 millió cikk található.

A Sci-Hub ezzel pótolhatatlan segítséget nyújt gyakorlatilag mindenkinek, aki nem valamelyik gazdag nyugati egyetemen/kutatóintézetben dolgozik, hiszen számukra pl. az Elsevier, Springer, Nature Publishing Group (NPG) lapjainak többsége, bármennyire is fontos a napi munkában, a kiadók kapzsi üzleti modellje miatt elérhetetlen lenne. Ez egyébként Elbakyan legfőbb érve is abban a perben, amit egy New York-i bíróságon indított ellene az Elsevier.

A per maga borítékolható volt, és aki akár érintőlegesen követte az Aaron Swartz elleni eljárást pár évvel ezelőtt, aligha lepődhetett meg azon, hogy a kiadók mindet bevetve igyekeznek védeni a nyereségüket. (Akkor a dolog tragédiával végződött, és az MIT rendszerén keresztül a JSTOR adatbázist „megcsapoló” Swartzt végül öngyilkosságba kergette az ügyészség agresszivitása.)

Sok szempontból persze tulajdonképpen az a meglepő, hogy ennyi ideig kellett várni egy Sci-Hub-szerű rendszer megjelenésére. A zene, film és könyvipart már évekkel ezelőtt alapjaiban rengette meg az internetes kalózkodás/terjesztés megjelenése, és a cikkek ilyen fajta terjesztése annyira evidensnek tűnik, hogy a Forbes már 1995-ben azt jósolta, hogy az Elsevier és az általa képviselt üzleti modell hamarosan irrelevánssá válik, hiszen a kutatók az új médium segítségével közvetlenebbül is el tudják juttatni cikkeiket az érdeklődőkhöz.

Az egyetlen, ami fenntartotta a rendszert, az a már korábban említett, s a szűkülő pályázati források miatt egyre fontosabb kvantifikációs kényszer volt. Az ez által alkalmazott, lapfüggő mérőszám, az IF, illetve az a meggyőződés, hogy a szerkesztési és bírálási folyamat olyan hozzáadott értéket teremt, ami pótolhatatlan, mind a szerkesztőségek malmára hajtotta a vizet.

De kérdés, hogy valóban az IF az egyetlen (vagy akár csak a legjobb) mérőszám, amit a tudományos életben használni lehetne, illetve valóban annyit ér-e a szerkesztőségi munka, mint azt sokan hangsúlyozzák? Egy egyre hangosabb tábor szerint nem és ők egy teljesen más publikációs rendszert képzelnek el a (nem is olyan távoli) jövőben, amiben a szerkesztőségeknek max. marginális szerepe maradna. Így jönnek képbe az ún. "preprintek".

A preprint publikálás lényege, hogy a kész cikkanyagot (még beküldés előtt) a kutatók feltöltik egy publikus adatbázisba, és lényegében attól a ponttól kezdve ország-világ láthatja, olvashatja az eredményeiket, nem kell megvárni, amíg végigfut egy sokhónapos bírálási folyamaton. Az ötlet nem új, és a matematikusok illetve fizikusok által használt, ezen az elven működő arXiv adatbázis már közel két és fél évtizedes múltra tekint vissza. Az ide felkerülő cikkek többsége aztán előbb-utóbb, a szerkesztőségi folyamat által eszközölt változásokkal, megjelenik valamelyik hivatalos lapban is, de az alapgondolatok többsége már az elején elérhetővé tett cikkből is kibogozható. És ami még fontosabb, a rendszer lehetővé teszi a publikáció utáni (post-publication) peer-reviewt, vagyis ha valaki nagy ostobaságot ír le, akkor azt előbb-utóbb kiszúrja valaki és mások tudomására hozza.

Az arXiv rendszere azonban bármennyire népszerű is volt a fizikusok között, valahogy soha sem tudott korábban népszerűségre szert tenni az élettudományok terén. A bizalmatlanság okában senki sem biztos: egyesek szerint a biológusok és orvosok egyszerűen csak nem ismerik a rendszert, mások pedig úgy vélik, hogy a preprint még nem IF-os publikáció és félő lehet, hogy valaki ellopja az ötletedet és még a te cikked „hivatalos” megjelenése előtt beleszövi saját cikkébe, amivel megfoszt a felfedezés hivatalos elsőbbségétől.

Mindenesetre korábbi, hamar elhaló próbálkozások után az elmúlt hónapokban egy új, minden eddiginél nagyobb hírverést kapó kezdeményezés jelent meg, hogy az élettudományok területén is felfuttassa a preprinteket: ez az Accelerating Science and Publication in Biology, vagy röviden ASAPbio. A cél itt is az lenne, hogy az élettelen természettudományok területén elterjedt publikációs szokásokat meghonosítsák, és arra biztassák a kutatókat, hogy a hivatalos beküldés előtt/mellett a kéziratuk eredeti formáját töltsék fel a sokasodó biológiai tematikájú preprint szerverekre – amelyek közül a bioRxiv és a PeerJ-Preprints talán a két legnagyobb. Ez meggyorsítaná a kutatásokat, hiszen a szerkesztés és bírálás mellőzésével, sokkal hamarabb értesülne mindenki új eredményekről, ami olyan vészhelyzetek esetében, mint az Ebola vagy Zika járvány életmentő lehet.

Nem mindenki lelkes azonban (bár amennyire a közösségi médián keresztül megítélhető, a többség valószínűleg igen). Az ötlet bírálói szerint a hagyományos újságok eddig is gyorsított eljárásban közölték a járványokkal kapcsolatos cikkeket, ugyanakkor a bírálási rész, a mitikus peer-review elhagyása könnyen ahhoz vezethet, hogy manifeszt kóklerségek és megalapozatlan eredmények is megjelennek majd, valódi cikkeknek álcázva a preprint szervereken.

Ez utóbbi érv ellen szól, hogy a tapasztalat azt mutatja, a peer-review az utóbbi években egyáltalán nem szűrt ki botrányos cikekket. A PLOS One alig pár hetes botránya csak a legutóbbi bizonyíték erre, de Wakefield vagy Seralini botrányos és kártékony pamfeletjei ugyanúgy megtalálták az útjukat hivatalos újságokba, mint Hwang Woo-Suk valószínűleg csaláson alapuló klónozós cikkei, a STAP-botrányt kiváltó cikkpáros, vagy a kapitális bénázáson alapuló arzén-alapú életet proklamáló cikk. És ezek nem valami félreeső, kis újságban jelentek meg, hanem a legelitebb lapokban, jól mutatva, hogy a Lancet, a Nature, vagy a Science sem immunis a kóklerségek publikálására.

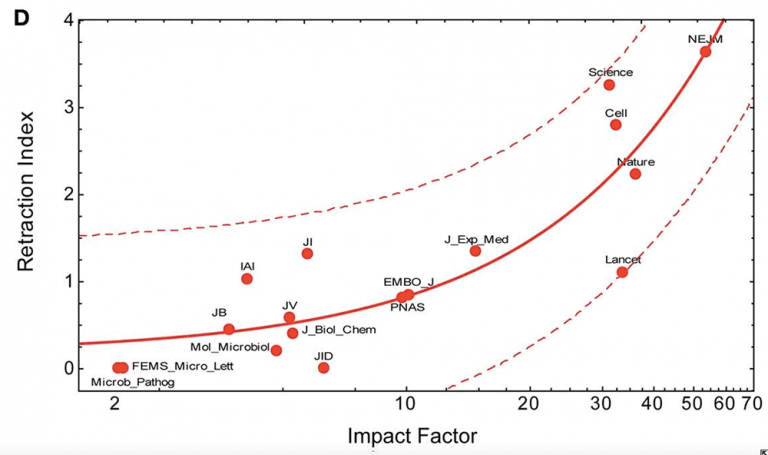

Sőt, a helyzet tulajdonképpen ennél is rosszabb lehet, ha elfogadjuk azokat az iparági felmérésket, amelyek szerint pl. a legfontosabb rákkutattási eredmények mindössze 11%-a reprodukálható, vagy ha megnézzük, mennyire gyakorik a retrakciók (cikkek visszavonása) az elit újságokban: az IF nem fordított arányban aránylik a retrakciók számához (amit várnánk, ha a komolyabb újságok szigorúbb szűrőt jelentenének), hanem egyenesen.

Maga a jelenség a rendszert belülről szemlélők számára nem váratlan: a nyomás alatt a kutatók igyekeznek, akár az adatokat is megszépítve nagyot mondani, váratlan eredményeket publikálni, hogy bekerüljenek a nagy presztízsű lapokba – azok pedig szeretik azokat a sztorikat, amelyek nagyot szólnak, sok emberhez eljut a hírük (mindez része a brandépítésnek). Ez a kettősség azonban minden, csak nem garancia az objektív, mértéktartó, nem szenzációhajhász publikációk közléséhez.

Szóval a fentiek ismeretében sokan amellett érvelnek, hogy a publikálás előtti peer-review kora lejárt, itt az ideje, hogy a preprintek által ambicionált publikálás utáni peer-reviewt éltessük - végülis ez volt az a folyamat, ami lebuktatta Woo-Suk és Obokata hamisítását, vagy az arzén-alapú élet szerzőinek amatőrségét is. A post-publication peer-review lehetővé tenné azt is, hogy fokozatosan elmozduljunk az IF-fetisizmus felől oda, hogy a cikkeket a valódi értékükön kezeljük, ami pont egybe esne a közel 12 ezer aláírással megtámogatott, 2012-es Declaration of Research Assesmnet (DORA) kezdeményezésben foglaltakkal.

De ha létrejön a legradikálisabb preprint forradalmárok álma, vajon marad-e létjogosultsága a hagyományos újságoknak? Úgy tűnik, s ebben váratlan egyetértés mutatkozik a barikád két oldalán, sokak szerint nem. Az OA egyik legnevesebb támogatója, Michael Eisen pont az ASAPbio kapcsán számol be arról, hogy az Elsevier kiadó álláspontja nem véletlenül hangzik furán a preprintek kapcsán: nincsenek ők a preprintek ellen, de ha egy preprintet már sokan elolvastak, akkor ők nem fognak foglalkozni a publikálással, mert bizonyos szempontból fölöslegessé váltak. Ez pedig megegyezik Eisen következtetésével is, még ha ő a másik irányból jut is erre.

A preprintek világában fölöslegessé válnak akkor a hagyományos lapok szerkesztőségei? A válasz itt bonyolult, mert szerkesztőség és szerkesztőség közt is ég és föld különbség lehet. Van ugyanis ahol nem nagyon termelnek hozzáadott értéket, elvégzik az adminisztrációt, kiküldik bírálni a cikket, mérlegelik a bírálatokat, majd a cikk elfogadása esetén betördelik azt a lap formátumába, de egyébként nem változtatnak sokat rajta. Ez a fajta szerkesztőség tényleg meghaladottá válhat a preprintek világában. De igazán elit helyeken a kéziratokat valóban gondozzák, több szerkesztő is felelős azért, hogy a végső szöveg a lehető legvilágosabban közvetítse a szerzőinek a mondanivalóját – egy ilyen szolgáltatás nem elhanyagolható egy olyan világban, ahol az angolul megírt cikkek többsége még a saját anyanyelvén is körülményesen fogalmazó, nem angol nyelvterületen élő kutatóktól származik. Erre a típusú szerkesztési hozzáállásra valószínűleg szükség is lenne, hiszen az olvasmányosabb, jobban megírt cikkeket többen megértik és idézik a későbbiekben. (Bár valószínűtlen, hogy azért ez a munka megérne cikkenként 3700 eurót, amennyit az NPG OA újságja, a Nature Communication számol fel publikálásnál...)

A másik nagy kérdés, hogy a most jól működőnek tűnő post-publication peer-review mennyire működne sok kommentelő esetében, nem ismétlődik-e meg a hagyományos komment-dobozok esete, ahol a nagyobb számú kommentelő, a trollok megjelenése miatt, a színvonal leromlásához vezetett. Hogy lehet majd ezt elkerülni/kiszűrni?

Az OA viharos elterjedésével és a preprint szerverek megjelenésével azonban tényleg minden adott, hogy véget érjen az Elsevier és társainak monopóliuma a tudományos információáramlás felett. De vajon tudunk-e élni az eséllyel?