A Facebook arra jutott, hogy jobb nem törölni az öngyilkos videókat

Nincs cég a világon, amely olyan hatással lenne felhasználóinak életére, mint a Facebook. Mark Zuckerberg kisvállalkozása 13 év alatt az egész világot behálózó tech- és médiaóriás lett, amelynek felhasználószáma lassan megegyezik a föld lakosságával. Hogy milyen tartalmak szerepelhetnek a Facebookon, az ma már nemcsak egyes emberek életét, hanem a média és a politika erején keresztül komplett országok, sőt, akár az egész világ sorsát meghatározhatja.

Ennek ellenére - vagy talán éppen ezért - eddig nagyon keveset tudtunk arról, hogy a rejtélyes fekete dobozként működő közösségi oldal mit tűr és mit tilt. A brit Guardiannak köszönhetően kicsit most oszlott a homály, miután vasárnaptól elkezdték publikálni a Facebook Filest, a Facebook belső használatra készült moderációs alapelveit, valamint az ezeket a dokumentumokat feldolgozó cikkeket.

A Facebook korábban soha nem engedett bepillantást azokba a munkafolyamatokba, amelyek alapján döntöttek egyes, a felhasználók által publikált tartalmak kicenzúrásáról vagy helybenhagyásáról. Pedig ahogy az oldal egyre népszerűbbé vált, mára pedig sokaknak szinte egyet jelent az internettel, úgy váltak egyre gyakoribbá a Facebook moderációs politikájával kapcsolatos botrányok.

Nagy port kavart az ügy, amikor a napalmtámadás után menekülő vietnami kislány képét letiltották, majd az azt közlő norvég újság oldalát is felfüggesztették. 2017-ben egyre többen gondolták úgy, hogy az új Facebook Live szolgáltatást kihasználva gyilkosságokat vagy öngyilkosságokat közvetítenek az egész világnak, amivel látszólag semmi baja nem volt Zuckerbergéknek. A Guardian által megszerzett dokumentumok most valamennyire segítenek eligazodni a Facebook döntéseiben, még ha egyetérteni mindegyikkel nyilván kevesen fognak.

Amerikában és Európában az utóbbi hónapokban egyre erősödtek azok a hangok, amelyek a Facebooktól követelték, hogy csináljon már valamit. Nemcsak a botrányos-véres egyedi ügyek váltották ezt ki, hanem a például az amerikai választások előtti és utáni pánik, amelyet az álhírek, a moszkvai dezinformációs hadműveletek, a liberális demokráciák megingása váltott ki.

A Facebooktól nem áll távol a felelősség elhárítása, nem véletlenül ragaszkodnak ahhoz következetesen, hogy ők egy tech- nem pedig médiacég, és így nem is kellene olyan szabályok szerint működniük, mint például egy minden általa publikált tartalomért felelős tévécsatorna. Egyre több politikus, szakértő, és persze a Facebook sikere által nehéz helyzetbe került médiacég viszont azt mondja, hogy Zuckerbergék szándékosan nem tesznek semmit a szélsőséges-véres-terrorista tartalmak ellen, ezért mindenképpen külső törvényi szabályozásra lenne szükség.

Abban azért nyilván mindenki egyetért, hogy az alapítói minden álmát ezerszeresen túlnövő Facebook mára akkorává duzzadt, hogy minimum nagyon nehéz, ha nem eleve lehetetlen feladat a hatalmas információáradatot nemcsak megnyugtatóan kordában tartani, hanem egyben a kellő sebességgel intézkedni a vitás ügyekben. A legfrissebb becslések szerint a kétmilliárd felhasználó percenként 1,3 milliószor publikál valamit - képet, szöveget, videót - az oldalon, ezt az információmennyiséget pedig nyilvánvalóan akkor sem tudnák folyamatosan, gyorsan ellenőrizni, ha a Facebooknak lenne 1,3 millió moderátora. De ennyi természetesen bőven nincs.

A cég ma 4500 embert foglalkoztat főállású moderátorként, és bár már bejelentették, hogy további 3000 főt terveznek felvenni ebbe a pozícióba, ez még mindig nagyon kevés. Azt tudni, hogy ezek a moderátorok nem mind a Facebook kaliforniai központjában ülnek, hanem szétszórva a világban, úgynevezett moderációs központokban, de az a cég üzleti titokként kezeli, hogy ezekből hány van, és pontosan hol találhatóak.

A Facebook nem csak ezek a moderátorok munkájára hagyatkozik, sőt. A cégnek folyamatosan fejlesztett intelligens eszközei vannak, amelyek automatikusan felismernek bizonyos típusú, sértőnek ítélt tartalmakat. A technika ma már ott tart, hogy egy meztelen férfit ábrázoló képet elég könnyen fel tud ismerni es szoftver, és gyorsan törölni is tudja azt. És ez csak egyetlen példa az a számtalan eset közül, amikor a Facebook hús-vér munkatársak közreműködése nélkül is tud intézkedni.

A moderátoroknak inkább akkor van dolga, amikor maguk a felhasználók jelentenek valamilyen tartalmat, ami már megjelent a Facebookon, viszont szerintük valami gond van vele. Ha ilyen feljelentés érkezik, a moderátorok háromféleképpen dönthetnek: nem csinálnak semmit, törlik a kifogásolt tartalmat, vagy - a különösen nehéz eseteknél - egy döntési szinttel feljebb delegálhatják az ügyet, közvetlen főnökeiknek.

A Guardian szerint a moderátoroknak, akiket egy kéthetes tanfolyam után engednek csak döntési helyzetbe, sokszor alig 10 másodperce jut egy-egy problémás ügyre. Ez már magában is elég stresszes helyzet, de ezt csak fokozza, hogy annak a 4500 embernek egész álló nap olyan fotókat és videókat kell végeznie, amelyek gyakran elmondhatatlanul brutális jeleneteket mutatnak be, a pedofíliáig és a kannibalizmusig bezárólag.

A leterhelt, egész nap kegyetlenségeket néző moderátorok számára az egyetlen szakmai és döntési útmutatást azok a témákra („állatkínzás”, „szex”, stb.) bontott kalauzok adják, amelyeket a Facebooknál folyamatosan frissítenek, figyelembe véve a törvényi környezetet és a különböző egészségügyi, biztonsági szakemberek ajánlásait. A brit lap szerint a Facebooknál létezik egy úgynevezett subject matter expert (SME), magyarul témaszakértő pozíció, amelynek betöltői folyamatosan tájékoztatják a moderátorokat az újabb és újabb belső szabályváltozásokról.

A különböző kényes szakterületek ellenőrzése, best practice-ek, azaz jó gyakorlatok kialakítása nagyon nehéz feladat, ahogy az önmagukban kárt okozó, öngyilkosságot elkövető felhasználók által feltöltött tartalmak esete is megmutatja.

A Facebook jelenleg nem törli az ilyen tartalmakat, mivel „nem akarják cenzúrázni vagy megbüntetni az olyan, eleve bajban lévő felhasználókat”. A cég azért döntött így, mert az ilyen emberekkel foglakozó segítő szervezetekkel konzultálva ez tűnt a legjobb megoldásnak. A tudomány mai állása szerint ugyanis „az ilyen helyzetben lévő emberek számára még mindig az a legbiztonságosabb, ha kapcsolatban maradnak a nézőikkel”. Az ilyen jellegű tartalmakat így csak akkor törlik, „ha már nincs mód a konkrét személy megsegítésére”, valamint ha magának a tartalomnak nincs egyéb szempontból hírértéke. Itt az utólagos törlés mellett pedig az szól, hogy a szakértők szerint az öngyilkosságra hajlamos emberek hajlamosabbak tényleg megölni magukat, amennyiben látnak ilyen tartalmú képet vagy videót.

A Facebook folyamatos kapcsolatban áll bűnüldöző és különböző segítő szervezetekkel is, ugyanakkor a moderátorok azzal kapcsolatban is nagyon pontos útmutatást kapnak, hogy melyek azok az öngyilkossággal fenyegetőzések, amelyeket komolyan kell venni, és esetleg cselekedni. Így például a „csak hashtagekkel és emoticonokkal” kifejezett öngyilkossági szándékokkal nem kell foglalkozniuk, és azokkal sem, amelyek öt napnál távolabbi időpontra ígérik halálukat. A Facebook szerint

„sokan egyfajta segélykiáltásként publikálnak ilyen tartalmakat, és ezekben az esetekben hiba lenne elhallgattatni ezeket a segélykiáltásokat”.

A moderátorok által használt útmutatók sok apró részletre kiterjednek, és bár a Facebook állítása szerint ezek mindig a jogi és egyéb szakértők tanácsai szerint készülnek, nem biztos, hogy a közösségi oldal felhasználóinak ízlésével is megegyeznek.

Ahogy a Guardian kiemeli, a „valaki lője le Trumpot!” felszólítást a moderátorok törlik, mivel egy konkrét személy ellen irányul, ugyanakkor az „ahhoz, hogy eltörd egy kurva nyakát, a torka közepén nyomd teljes erőből” illetve a „menj a picsába és dögölj meg” szövegeket nem cenzúráznák, mivel ezek nem minősülnek hihető fenyegetésnek.

Néhány a hasonlóan nyakatekert, de persze lehet, hogy a jogászok és a téma szakértői által teljesen korrektnek tartott moderátori gyakorlatok közül:

- Vannak olyan, gyermekbántalmazást ábrázoló képek, amelyeket nem kell törölni, amennyiben azoknak nincs szadista, magát a bántalmazást ünneplő eleme.

- Az állatkínzást ábrázoló képek maradhatnak, ezek közül csak a legbrutálisabbakat kell figyelmeztető címkével ellátni a felhasználók felé. A videókat viszont jó eséllyel törlik.

- Minden „kézműves” eszközökkel készült, meztelenséget vagy szexuális aktust ábrázoló tartalom maradhat, de a digitális módszerekkel készült, szexuális aktust ábrázoló műalkotásokat törölni kell.

- Az abortuszt megjelenítő videók maradhatnak, amennyiben nem mutatnak meztelenséget.

- Akinek több mint 100 000 követője van bármely közösségi csatornán, az közszereplőnek minősül, és így személyiségi jogait is kevésbé védik, mint a magánemberekét.

Amellett, hogy a Facebooknak nehéz dolga van, amikor konkrét feljelentett tartalmak esetében kell döntenie, van egy magasabb szintű eldöntendő kérdés is, nevezetesen hogy miként tudják az ártalomcsökkentés jogos igényét összeegyeztetni a szólásszabadság és az információk szabad áramlásának elvével. A Guardian által megszerzett dokumentumban a cég úgy fogalmaz, hogy céljuk

„olyan környezet megteremtése, amelyben mindenki megnyilvánulhat bármely témában, és kifejtheti a véleményét úgy, hogy tiszteletben tartja mások jogait”.

Majd kifejtik, hogy

„amikor sok millió ember összejön, és számukra fontos dolgokat osztanak meg egymással, gyakran érintenek olyan témákat, amelyek vitát váltanak ki. Mi abban hiszünk, hogy ezek a viták és eszmecserék hasonlóak azokhoz a beszélgetésekhez, amelyeket az emberek az offline életükben folytatnak, otthonukban, munkahelyükön, kávézókban vagy az osztályteremben”.

Ami nagyon szépen hangzik, de talán éppen arra világít rá akaratlanul is, hogy ahogy a való életben sincs mindig jó megoldás az erőszakra, gyermekbántalmazásra vagy állatkínzásra, úgy a Facebook sem lehet arra képes, hogy ezek online megnyilvánulásaira mindig jó választ adjon.

A Guardian készített egy rövid tesztet is, amivel bárki kipróbálhatja, hogy alkalmas lenne-e moderátornak a Facebooknál. Jó játék.

Nem kezeli többé gyerekpornóként a Facebook a világ egyik legismertebb háborús fotóját

Eddig mindenkit letiltottak, aki kitette, most belátták, hogy ez hülyeség volt.

Öngyilkos lett a Facebook-gyilkos

Rendőrségi hajsza közben végzett magával az a férfi, akit azzal vádoltak, hogy a hétvégén élőben közvetítette a Facebookon egy 74 éves férfi megölését.

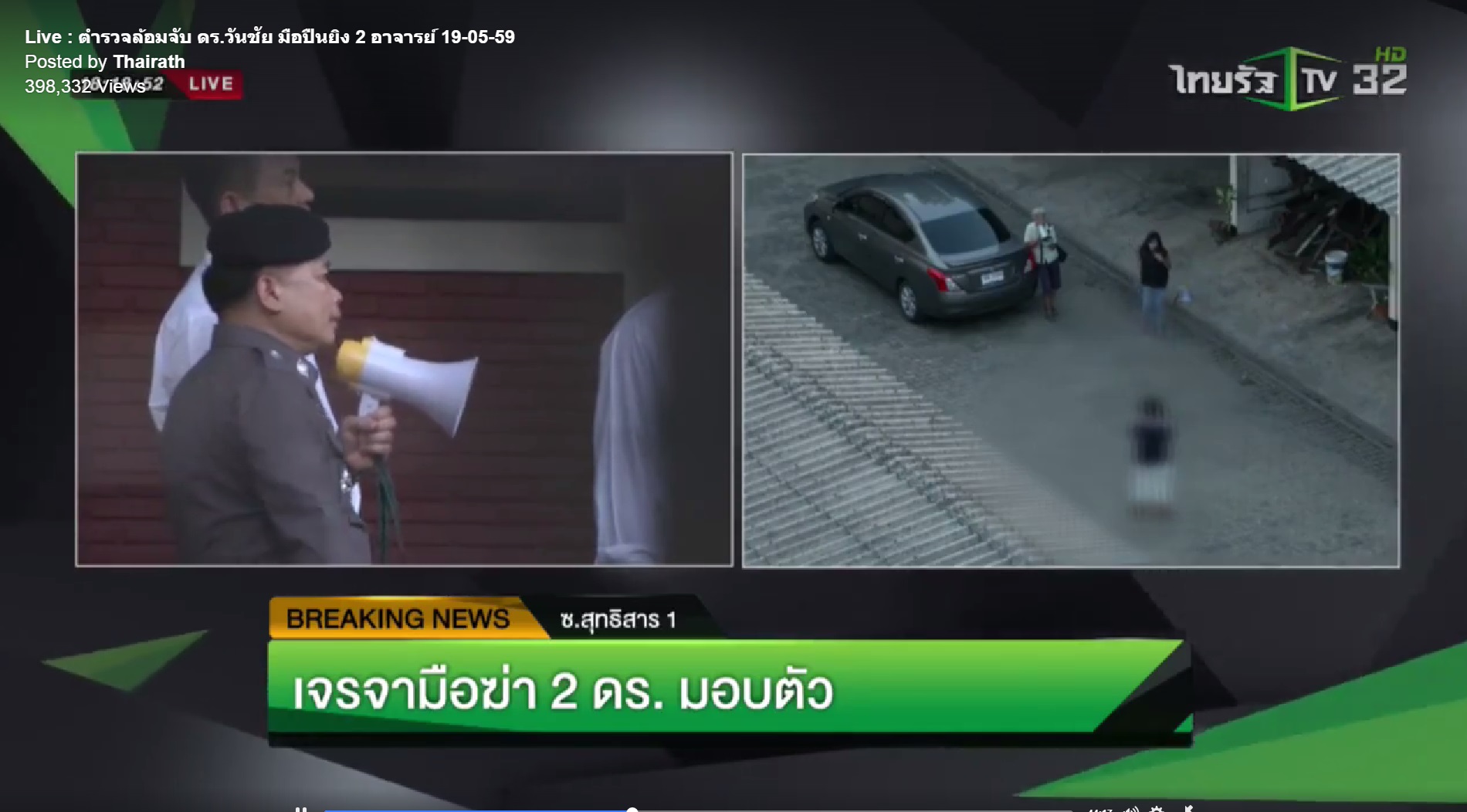

Több mint 40 ezer ember nézte élőben a Facebookon, ahogy egy egyetemi tanár fejbe lövi magát Bangkokban

Ahogy terjed a közösségi médiában az élőzés, egyre bizarrabb dolgok kerülnek adásba.

Merkel végre személyesen is letámadhatta Zuckerberget a Facebookos gyűlölködés miatt

Bekapcsolva maradt a mikronfon. Zuckerberg magyarázkodott.

A Facebook mint morális pánik

Lehet, hogy néhány éven belül elsüllyedünk az álhírek világában, de adjuk meg az esélyt annak a lehetőségnek is, hogy megtanuljuk helyükön kezelni ezeket. A média és a manipuláció nem most talált egymásra.