Jön az automatizált fegyverek kora

Stanisław Lem lengyel író – aki meglepően sok mindenre érzett rá idejekorán – az 1985-ös Béke a Földön című szatirikus regényében arról írt, hogy az egyre drágább és követhetetlenebb fegyverkezési versenyt megelégelve a Föld kormányai megegyeznek, hogy minden tömegpusztító eszközt kitelepítenek a Holdra. Csakhogy az önreprodukáló, értelmes fegyverek ott további fejlődéseken mennek keresztül, míg végül az emberiség arra nem eszmél, hogy a por, amiből egyre többet látnak a Földön, valójában a földi civilizáció ellen forduló fegyverek legfejlettebbike.

Frank Pasquale A robotika új törvényei – Az emberi szakértelem védelme az AI korában című könyvéről szóló ijesztő cikkében a Guardian arról számolt be, milyen közel kerültünk mostanra a sci-fikből ismert robothadseregek, kiberterroristák és AI-vezérelte tömeggyilkosságok világához. Erre figyelmeztetett a 2017-es Slaughterbots című rövidfilm is, amit az emberi élet jövőjéért aggódó civilek készítettek: ebben terroristák egy furgon mellől, távirányítóval vezérelt, kisméretű okosdrónokkal mészárolnak le egy iskolát.

Már a valóságban is léteznek apró, rovarokhoz hasonlító felderítő drónok, amik felvételeket készíthetnek, és messzire elküldhetik a jeleket. Csak rövid idő kérdése, hogy ezeket is fegyverekkel szereljék fel.

Nem biztos, hogy a robot jobban dönt az embernél

Az emberiség a 20. század közepe óta igyekszik korlátozni a vegyi és atomfegyvereket, és sok szervezet összefogásával el is érték, hogy ezek közül sokat tiltsanak be, aki pedig ezt megszegi, azt kizárják a nemzetközi közösségből. Így járnak el az autonóm harci fegyverekkel szemben is, csakhogy a világ legnagyobb hadseregei a háttérben ugyanúgy fejlesztik azokat abban a félelmében, hogy a riválisaik is ezt teszik, úgyhogy meg kell védeniük magukat egy ellentechnológiával. Ahogy pedig a hadsereg visszatér külföldről, a hadiipart is magával hozza, így látható, hogy az emberek bármilyen haditechnikát engednek meg az országuknak külföldön, azt később akár ellenük is bevethetik otthon.

A robotizált rendszereknek lehet előnyük is, ha ki tudják vonni a számításból az emberi kegyetlenséget: ha mondjuk kivonják az embereket a célzással kapcsolatos döntésekből, és etikai korlátokat programoznak a robotokba, azzal például meg lehetne előzni a kórházak és iskolák elleni felesleges támadásokat. Csakhogy a történelem során rengeteg hideg fejjel megtervezett tömeggyilkosság történt, és nem lehet kétségünk afelől sem, hogy lesz olyan ember, aki a robotokat felülbírálhatja.

A gyilkos robotok beprogramozása az etikai szabályok követésére rengeteg gyakorlati nehézséget vet fel. Noel Sharkey informatikaprofesszor szerint lehetetlen a robotharcosokat programozással felkészíteni a konfliktusok hevében felmerülő helyzetek végtelen variációira. Olyasmi ez, mintha egy önvezető autó szenzorait állandóan hófúvás zavarná, a háború ködében is veszélyes lehet egy autonóm fegyverrendszer. (Arról, hogy az önvezető autókkal kapcsolatban mennyi elméleti probléma merül fel, két éve írtunk.) A hirtelen kialakuló, zavaros helyzetekben a komplex etikai szabályok követése szinte lehetetlenné válhat. Emiatt aztán valószínűbb, hogy a hadseregek ezeket egyszerűen megspórolják, és marad a bűntudat nélküli pusztítás.

Honnan tudja bárki, ki a célpont?

A nemzetközi emberi jogi törvények szabályozzák a fegyveres konfliktusokat, ezeknek egyik alapja a harcoló felek és a civilek megkülönböztetése. De a gerillák és a hibrid hadviselés korában a katonák sem mindig viselnek egyenruhát, így egyre nehezebb a megkülönböztetés. Hogyan lehetne akkor ilyen területen általános szabályokat hozni az automatizált fegyverrendszereknek?

De még ha így is lenne, miért feltételeznénk, hogy a parancsnokok ne állítanák be ezeket úgy, hogy a lehető legtöbb dolog férjen bele a harcoló fél fogalmába? Grégoire Chamayou francia filozófus azt írta, hogy a „harcos” (legitim célpont) kategóriát már annyira felhígították, hogy az sokszor kiterjed nemcsak egy fegyveres szervezet tagságára, hanem az azzal együttműködőkre vagy akár vélelmezett szimpatizánsaira is.

Honnan tudjuk, mi fér bele?

De nem csak a különbségtétel jelenthet problémát. A nemzetközi jog előírja azt is, hogy egy katonai hadműveletnek „arányosnak” kell lennie: a civil lakosságnak okozott potenciális kárnak és a hadművelettel nyerhető előny mértékének egyensúlyban kell lenniük. Az amerikai légierő szerint ez eredendően szubjektív megítélés kérdése, így ezt minden egyes esetben külön kell vizsgálni. Mindegy tehát, a technológia milyen jól ismeri fel és semlegesíti a fenyegetéseket, nincs bizonyíték arra, hogy képes lenne finoman és rugalmasan érvelni a kissé kétértelmű törvények vagy normák szempontjából.

Samuel Moyn történész egy paradoxonra is felhívta a figyelmet: a háborúk humánusabbakká váltak, viszont nehezebb is azokat befejezni. A robotok viszont a megszállóknak megspórolják a magyarázkodást odahaza az elesett katonák miatt, ráadásul pusztán a megfigyelőképességükkel képesek pacifikálni az ellenséget, elkerülve a pusztító vérontást, ami forradalmat vagy nemzetközi beavatkozást váltana ki.

A robotizált hadviselés inkább olyan lenne, mint egy rendőrségi akció: a nyílt ellenségeket lecserélnék a gyanúsítottak, akiket halálos erő bevetése helyett gépi őrizetbe vennének. Moyn szerint ezzel ugyan sok életet menthetnénk meg, de a technológiai fejlettségbeli különbség mégsem lenne megfelelő alapja egy legitim nemzetközi rendnek. Chamayou szerint ráadásul felmerül a kérdés, hogy ha már az intelligens rendszerek eleve megelőzik a harci cselekményeket, hogyan tudnak különbséget tenni ellenség és civil között.

A dühös nacionalizmus az automatizációnak kedvez

A cikk egy könnyen érthető példával érzékelteti, mennyire nem valószínű, hogy a vezető katonai hatalmak rászánnák magukat az automatizált fegyverek korlátozására. Már az első világháborúban használt taposóaknák is korai automatizált fegyverek voltak: megsemmisítik/megfélemlítik az ellenséget, és felügyelet nélkül is működik. Olcsó előállítani, és könnyű használni, 1994-re már kb. 100 milliót telepítettek 62 országban.

Csakhogy évekkel a háború után is pusztító hatásuk lehet: 1994-ben minden 236. kambodzsai elvesztette miattuk legalább egy végtagját. Addigra konszenzus volt arról, hogy be kéne tiltani a technológiát, 1997-ben Nobel-békedíjat is kapott az erről szóló kampány, több tucat ország írt alá egy nemzetközi egyezményt arról, hogy nem gyárt, raktároz vagy telepít ilyen aknákat.

Csakhogy az Egyesült Államok ebbe nem állt bele, és az Egyesült Királysággal együtt amellett érveltek, hogy a megoldás az lenne, ha csak bizonyos ideig működnének az aknák, vagy távirányítással ki lehetne azokat kapcsolni, és ha szükséges, visszakapcsolni. Ezt kevesen támogatták, de az eredeti egyezményt egyre többen, 2010-re már Kína is csatlakozott hozzá. Ugyan Obama kormányzata tett néhány lépést az aknák korlátozása felé, Trump elnöksége alatt Amerika visszafordult ebből az irányból.

Mit vagy kit szabályozzunk, és hogyan?

A tiltás helyett az amerikai hadsereg a szabályozást részesíti előnyben. Az automatizált fegyverek meghibásodásaival vagy más nem szándékos következményeivel kapcsolatos aggodalmak a katonai robotika körüli vitákat eredményeztek.

P. W. Singer, az Új Amerika Alapítvány politikatudósa, aki a 21. századi hadviselésre specializálódott, úgy véli csak nem halálos fegyverekkel operáló gépeket szabadna automatizálni, tehát egy drón mondjuk hálót kivethetne egy katonára, de az emberölésről csak emberi felettes dönthetne, még akkor is, ha a katona el akarná pusztítani a drónt. Így a háborúból könnyebben válhatna békefenntartás, és az elfogás és a halálos ítélet között eltelő idő segítene megfontoltabb döntést hozni.

Szerinte az elszámoltathatóság is fontos: ha egy programozó miatt egy egész falut felrobbantanak tévedésből, akkor büntetőjogi felelősséggel tartozik. Ahelyett, illetve amellett, hogy a robotokba etikát programoznak, biztosítani kell, hogy a „háborús algoritmusok” fölött legyen valaki, akit számon lehet kérni. Ilyen lehetne például valamiféle sorszám a drónokon, hogy bármilyen helytelen működés számon kérhető legyen az irányítójukon vagy tervezőjükön.

De itt is felmerül a kérdés, mennyire valószínű, hogy a drónok programozóit megbüntessék, amikor például 2015-ben az amerikai hadsereg lebombázott egy afgán kórházat, megölve 22 embert, hiába könyörögtek a bombázás közben is a kórházban dolgozók, hogy álljanak le. Sok másik eset is volt, amikor drónokkal támadtak kórházakat, iskolákat vagy esküvőket, és hiába volt ezeknek ember a felelőse, megúszták a büntetést. Ezek után egy programozót miért kérnének számon?

Az elit globális projektje mindenki ellenőrzésére

A háború mindig is óriási üzlet volt, egy AI-lapú fegyverkezési verseny pedig még nagyobb lehet. A katonai és a megfigyelő mesterséges intelligenciát elsősorban most sem külföldi, hanem belföldi ellenségek ellen használják. Bár 2001. szeptember 11. óta nem történt hasonló terrortámadás az USA-ban, a biztonsági erők titokban már sima bűnözők, biztosítási csalók vagy akár tüntetők ellen is használnak terrorelhárító eszközöket, Kínában pedig a legmodernebb technológiával zajlik az ujgurok átnevelése.

Nem meglepő hát, hogy kínai technológia működtet amerikai belföldi hírszerzési eszközöket, miközben a kínai kormány amerikai technológiai cégeket von be a projektjeibe. A mesterséges intelligencia használatának terjedése a katonaságban, rendőrségben, börtönökben és biztonsági szolgálatoknál kevésbé a nagyhatalmak közötti versengésről szól, inkább a vállalati és kormányzati elit jövedelmező globális projektje, aminek a célja a belföldön és külföldön tartózkodó nyugtalankodó népesség feletti ellenőrzés fenntartása – írja a könyv, ami szerint a megszállt területeken használt technológiát hazaviszik, és először népszerűtlen vagy marginális csoportok ellen vetik be, aztán kiterjesztik mindenki másra.

Pedig nem minden társadalmi problémára megoldás az állandó megfigyelés. Ahogy az a Közel-Keleten is látszik, Amerika hosszú évekig képes megszállva tartani területeket, részben a megfigyelő drónoknak köszönhetően. Csakhogy miközben viszonylagos nyugalmat tudnak fenntartani, közben az állandó megfigyelés – az elnyomás egyik fajtája – frusztrációt, dühöt vált ki, és hosszú távon kontraproduktív.

Rosa Brooks, a Pentagon volt tisztségviselője szerint amerikai védelmi szakértők egyre inkább felismerik, hogy a fejlesztések, a jó kormányzás és a humanitárius segítségnyújtás legalább olyan fontos a biztonság szempontjából, mint a katonai jelenlét. Ha az USA csak töredékét fektette volna a felesleges katonai kiadásainak az egészségügybe, több 10 ezer emberrel kevesebb halottja lenne a koronavírus-járványnak is.

A kooperáció és a béke fenntartása az AI-fegyvereknél jobban segítene elkerülne a zéró összegű, végeláthatatlan háborúkat. (A magunk részéről pedig igyekezzünk átverni az utánunk szaglászó drónokat.) (Guardian)

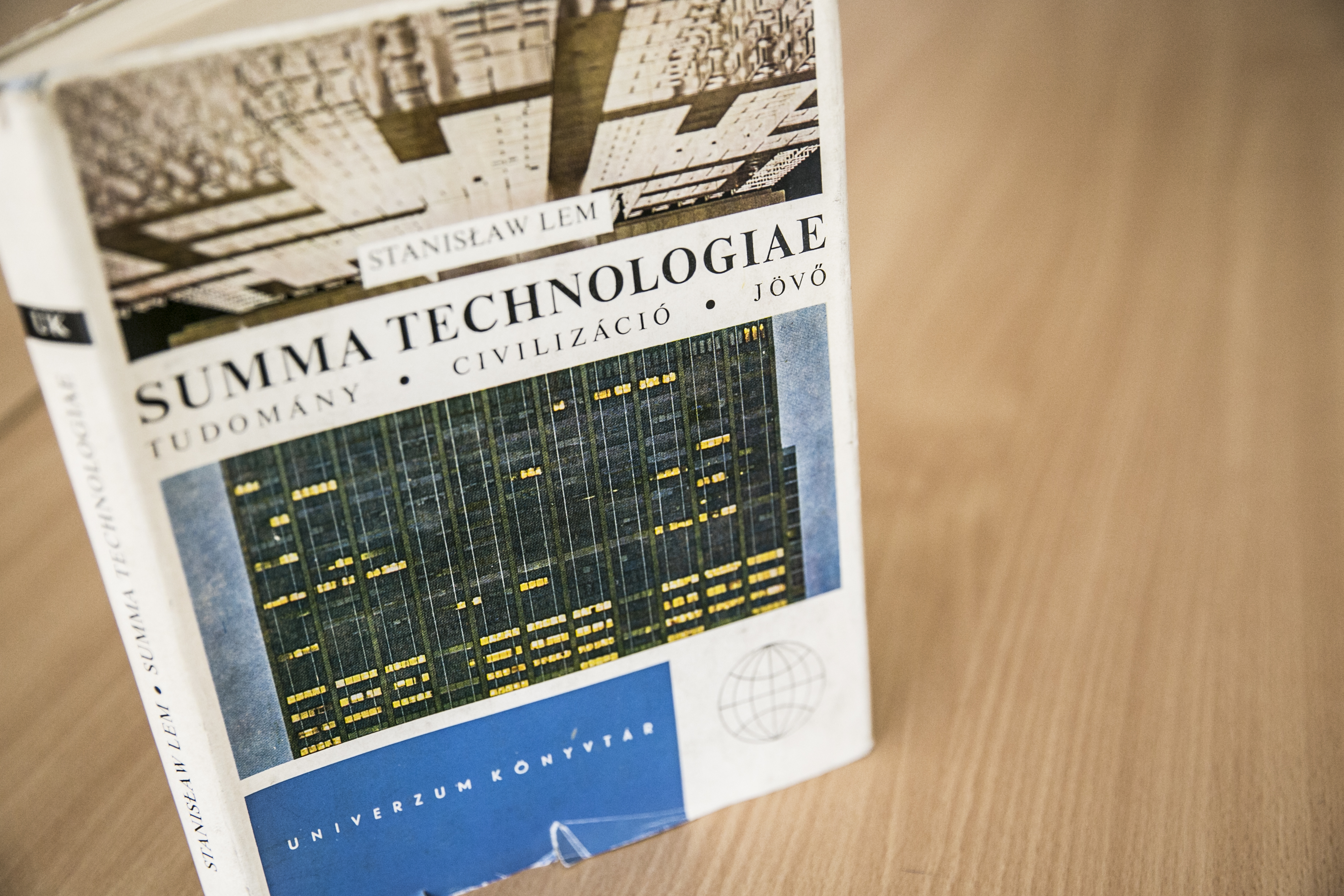

Summa Technologiae – igazságot Stanisław Lemnek!

1963-ban, a kommunista Lengyelországban egy sci-fi-író több mint 50 évvel megelőzte az elmúlt évek sikerkönyvét, a Harari-féle Homo Deust. Azóta Lem jövőkutató esszéi szinte semmit sem veszítettek az aktualitásukból.

Senkinek nem jó, ha a rendőrök katonákká válnak

Kell-e kommandósokat hívni, ha egy nő tányérokat dobál ki az ablakon? Hát ha egy tökfesztivál biztonságára kell vigyázni? A rendőrség militarizálódása az USA-tól Magyarországig létező jelenség. És probléma.

Lehet, hogy jön az eddigi legnagyobb MI-tél

Az 1950-es évek óta többször is elfogyott a mesterséges intelligencia iránti lelkesedés. Most viszont szárnyal az ipar, pedig vannak baljós jelek. Az állami támogatások keresése, az önvezető autók hibái és az egyre több szkeptikus fejlesztő csak a kezdet.

Ha eddig nem gondoltad, hogy Kínában totális diktatúra van, akkor nézd meg a Vice ujgurokról szóló filmjét

Az újságírók magukat turistának kiadva jutottak el ujgurok lakta vidékekre. A szellemvárosokban rendre totális megfigyelésbe, fenyegetésbe, vegzálásba futottak.

Hogyan verjük át a drónt?

Néhány tipp, ami még hasznos lehet a megfigyelési kapitalizmus korai szakaszában.